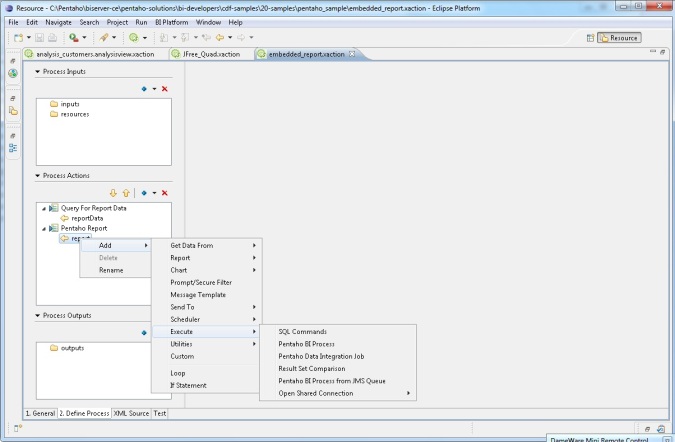

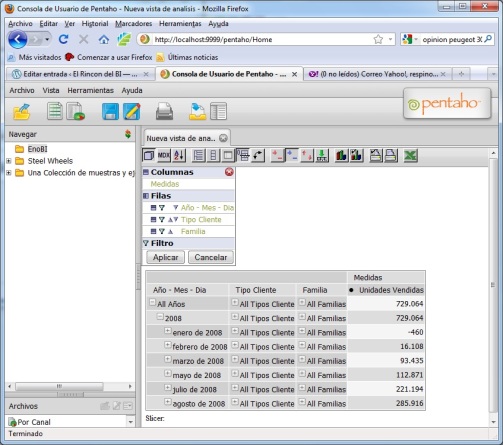

Durante los dos ultimos meses he estado peleandome con Pentaho y su plataforma BI, y no puedo negarlo, mis sensaciones con la plataforma no han sido buenas. Entiendo que estamos hablando de un producto OpenSource, gratuito, elaborado con la colaboración desinteresada de mucha gente. Pero el hecho de tener que estar continuamente tocando ficheros, tener que repetir las mismas acciones con cada herramienta que utilizamos, tener que tener conocimientos sobre aspectos que quedan fuera de lo que es el Business Intelligence en sí y que se parecen mas a una artesanía tecnológica no me han terminado de convencer. Además, la documentación sobre muchos aspecto es muy floja y no queda más remedio que la prueba/error y la experimentación para conseguir que muchas cosas funcionen. Cuando se producen errores, también es complicado hacer una depuración y llegar al quit de la cuestión sin dificultad. También se nota en demasia que estamos hablando de diferentes herramientas que ha sido integradas en una plataforma y no forman una verdadera suite todavía, a las que aun les queda mucha evolución por delante.

Entiendo que esas tareas pueden ser una parte importante de un proyecto, pero me han hecho desviar demasiado la atención de lo que pienso que es realmente importante cuando estamos hablando de un sistema de este tipo. Yo no intento aprender Java, o sobre Apache o Ajax, quiero montar una plataforma en la que quiero dedicarme a lo importante de un proyecto BI, y no tener que perder tanto tiempo en aspectos tecnológicos que pueden ser interesantes pero que no me aportan nada. Y si lo comparo con la experiencia y el feeling obtenido, por ejemplo, al utilizar la Microstrategy Reporting Suite (gratuita también, por cierto), la cosa para mi no tiene demasiado color. Todo esto, unido al siguiente parrafo que me encontre en la guia de usuario de la community edition:

Pentaho no longer suggests using Community Edition for enterprise evaluations. If you are a business user interested in trying out the BI Suite Enterprise Edition, follow the Enterprise Edition evaluation link on the pentaho.com front page, or contact a Pentaho sales representative. The enhancements, service, and support packaged with the BI Suite Enterprise Edition are designed to accommodate production environments, especially where downtime and time spent figuring out how to install, configure, and maintain a business intelligence solution are prohibitively expensive. If your business will save money or make more money as a result of a successful business intelligence implementation, then Enterprise Edition is the most appropriate choice.

Este texto termina de confirmar mis dudas sobre el producto. Entiendo que las versiones Enterprise estarán mas elaboradas, además de contar con el soporte técnico que proporciona el fabricante. Pero para eso seguramente, desde mi punto de vista de gestor de un departamento de informática, en el caso de tener que elegir un producto para un proyecto BI, me decantaría por un producto propietario, quizás con un coste superior, pero con un nivel de integración mayor, mejor documentación, mayor estabilidad tecnológica y el soporte de una empresa involucrada en el desarrollo y con una base amplia de clientes de todos los niveles. Puede que este perdiendo posibilidad de integración con otros sistemas y me este casando con un único producto en el que tendré menos posibilidades en algunas cosas, pero seguramente eso no me haga falta en circunstancias normales.

Esto no es un alegato en contra del software Open Source, en el que creo firmemente y del que utilizo muchas herramientas, tanto a nivel personal como dentro de mi organización (Ubuntu, MySQL, Eventum, Untangle, OpenOffice, MailScanner, Talend, Kettle, VisualParadigm, Apache, etc), pero me apunto a los comentarios que hacía Pau de BI Facil en su blog. En el se hacen consideraciones muy interesantes sobre las herramientas Open (y su utilización en proyectos BI) y que os voy a recordar, pues, desde mi punta de vista, ha acertado de pleno con lo que yo pienso sobre el tema:

"Que un programa tenga el código fuente disponible es una buena cosa. Sin duda. Puestos a escoger, prefiero utilizar software del que pueda ver y/o modificar el código. Esto me dará independencia y me dará una cierta tranquilidad incluso en el caso de que el fábricante desaparezca. En la práctica, sin embargo, no creo que deba ser un criterio fundamental para la elección de software. Mi empresa (¿y la tuya?) no se dedica a fabricar software, por lo que no tiene ni los conocimientos, ni el interés, ni las ganas de modificar el código fuente de nuestros aplicativos. Aunque suene impopular: Tengo más asegurada la continuidad de Microsoft Word (de código privativo), que el de Pentaho (de código abierto). Por razones evidentes."

Totalmente de acuerdo. No me veo, con los recursos de los que normalmente disponemos en una empresa media, que nos pongamos a modificar el código fuente de un producto de este tipo (con miles de lineas de código) o nos pongamos a buscar un error que se produzca en un momento determinado. Si puede ser que esto nos permita realizar alguna personalización o algún desarrollo puntual para un tema especifico, pero requeriremos un experto en Java o en desarrollo Web para hacerlo con garantías. Todo un reto.

"Que el software sea gratis o de bajo coste es una buena cosa. Sin duda. Puestos a escoger, prefiero utilizar software que sea gratis. Sin embargo, no debemos equivocarnos: los proyectos “open source” tampoco son gratuitos, ya que su negocio suele estar en la consultaría, en el soporte, o en otros servicios asociados. Personalmente, preferiría una aplicación que fuese tan fácil de utilizar que no requiriese consultoría (o que fuese lo menor posible), ya que a la larga los costes de consultaría y mantenimiento pueden superar con creces los costes de hardware y software. Es decir: Tampoco el coste es un criterio definitivo para la elección de una herramienta. Existen otros parámetros más importantes: Funcionalidad, facilidad de uso y administración, estabilidad, etc."

Aquí Pau vuelve a dar otra vez en el clavo. Seguramente en un proyecto BI cambiando herramientas propietarias por Open Source estamos trasladando los costes de licencias a coste de consultoria, desarrollo y mantenimiento. Y coincido con el en que el tema del coste no ha de ser definitivo, pero si la funcionalidad, facilidad de uso y administración, estabilidad, documentación, soporte, solución de bugs, sin tener que ponernos a bucear en las tripas de un producto que habra sido desarrollado con herramientas en las que no estaremos especializados y en la que nuestra capacidad de actuación no tendra demasiadas garantias en comparación con la del soporte del fabricante en un producto evolucionado e integrado.

"Finalmente, el concepto de “software colaborativo” es el que me resulta más extraño. ¿Qué me importa a mi, como comprador de software, que el software lo haya hecho un equipo de profesionales a sueldo de IBM o una comunidad de internautas en sus ratos libres? De hecho, éticamente, me siento más cómodo comprando algo cuyos autores han resultado debidamente pagados, y que genera empleo, y tal… No sé si me explico. El próximo comentario tratara sobre este asunto (después de haber leído ciertas cosas estoy cabreado, y prefiero no escribir en caliente)…"

"En definitiva, en mi opinión, la única viabilidad que tienen las empresas Open Source es entrar de lleno en mercado, y jugar con las reglas del mercado. Sólo si sus productos son mejores, podrán ganar terreno al software “privativo” (así denominan al software comercial habitual)."

Creo que Pau vuelve a bordarlo con este comentario. El Open Source puede ser una opción de entrada, pero solo creo que sus productos triunfaran si entran en las reglas del mercado (como esta haciendo, por ejemplo, Pentaho) y son mejores que sus competidores.

Conclusión final.

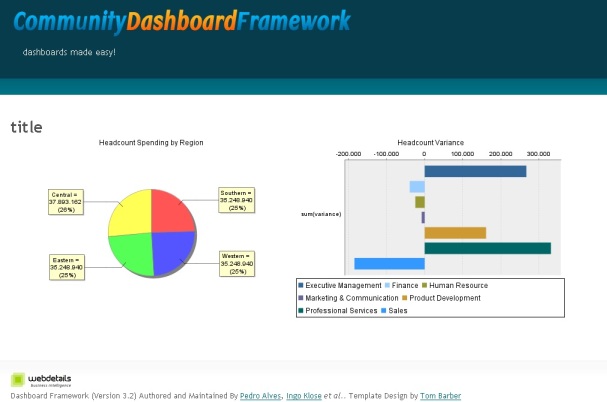

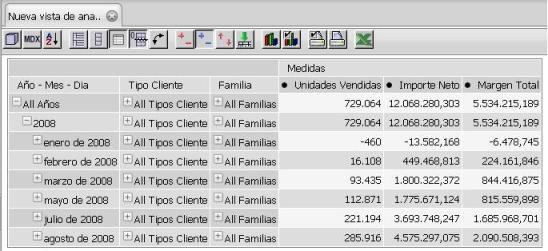

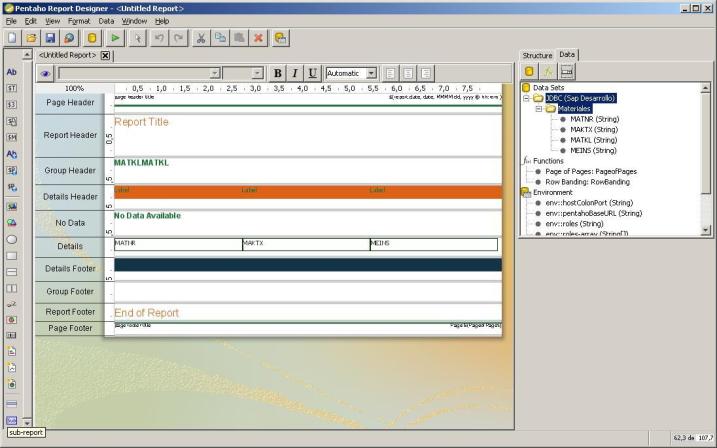

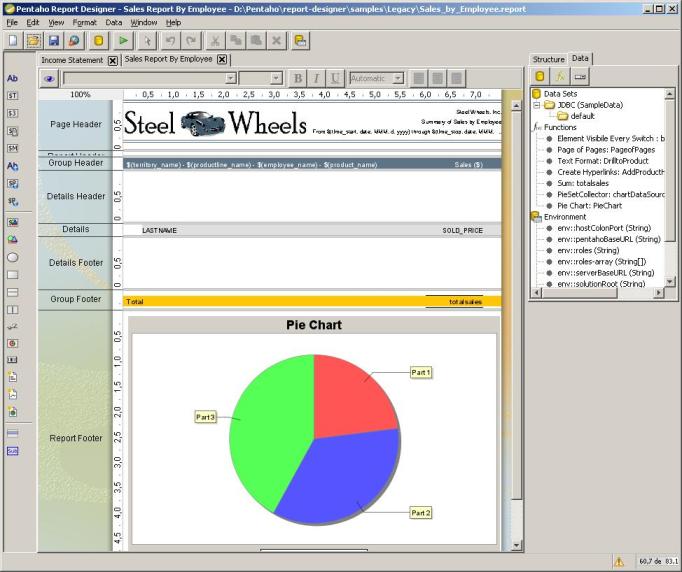

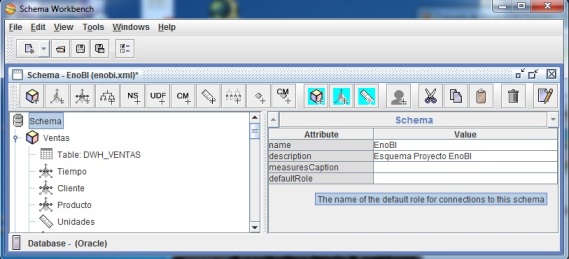

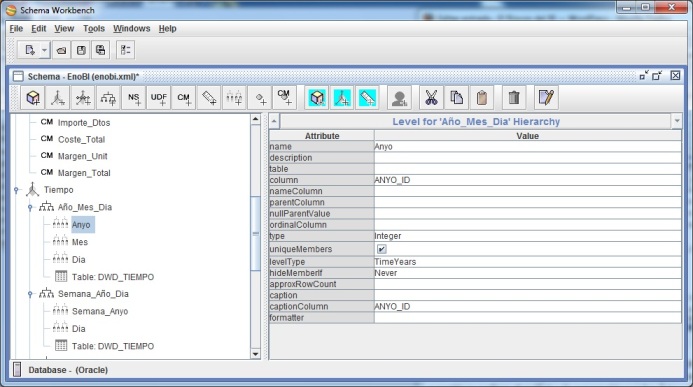

Aunque la experiencia Open Source ha sido muy satisfactoria en la parte de herramientas de integración de datos (tanto Pentaho Data Integration como Talend han cubierto de sobra mis requerimientos, ademas de ser herramientas muy evolucionadas, con muchisimas funcionalidades y estables), no puedo decir lo mismo en la parte de la Plataforma BI y las herramientas de análisis, por todo lo que he descrito en los parrafos anteriores. Además, a nivel de funcionalidades, creo que todavia no se puede establecer una comparación de igual a igual entre un producto como Microstrategy (que es el que he utilizado yo en mis análisis) y Pentaho. Y supongo que lo mismo ocurrira si nos vamos a Sap (BW o Business Objects), Oracle (OBIE) o IBM Cognos. Quizas este comparando cosas que no tienen mucho que ver, pero una vez he conocido las funcionalidades de un producto así, la evaluación de Pentaho ha sido bastante desilusionante para mi.

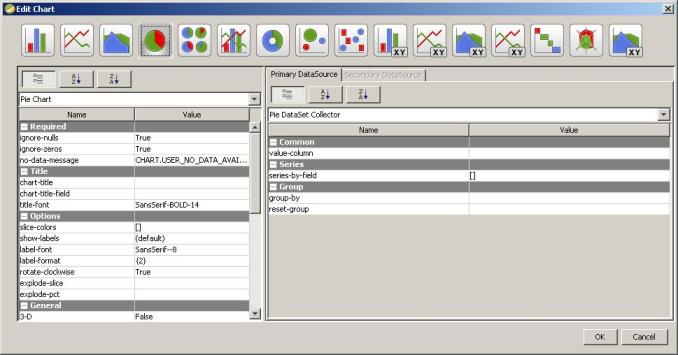

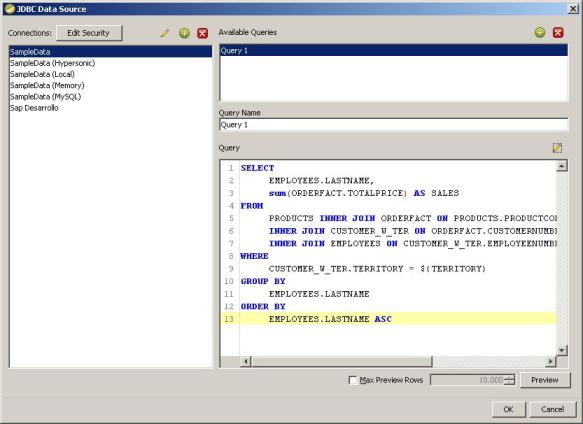

Entiendo que el producto tiene potencial de futuro y una gran evolución por delante, pero aun le queda muchisimo para llegar al nivel de las grandes. Y si, siendo un producto Open Source da bastantes funcionalidades que quizas puedan ser suficientes para muchas organizaciones, eso no lo discuto. Pero yo veo algunos peros y dudas que no me terminan de convencer, aunque ha habido productos que me han gustado bastante, como Kettle, PRD, y otros no tanto como Mondrian o CDF (donde tenemos que ser programadores para hacer nuestros tableros y cuadros de mando). Para mi es fundamental que la herramienta sea fácil de usar, para que, incluso usuarios no técnicos puedan sacar todo el partido de ella, sin necesidad de tener la dependencia del departamento de informática de toda la vida. Seguramente prefiera estar pagando licencias y actualizaciones anuales (para las nuevas funcionalidades), que estar pagando programadores y consultores, y estar sacando todo el partido de la herramienta sin necesidad de perfiles tan técnicos, centrandome en lo importante de la Inteligencia de Negocio, que es el análisis y la extracción de conocimiento de los datos.

NOTA

Gracias a Pau, de BI Facil, hemos conocido el blog La Pastilla Roja. Hay un interesante entrada sobre los criterios y cosas a tener en cuenta a la hora de «hacer el cambio» al Open Source. Creo que se mencionan cosas muy interesantes que pueden ser válidas en nuestra proceso de decisión de «pasarnos» al otro lado.